Вы уже знаете, как защитить свой сайт от кражи контента и что делать, если его все же украли. Сегодня продолжим говорить о проработке SEO. У веб-мастеров часто появляется необходимость ограничить доступ ко всему сайту или каким-либо его разделам. Практически на любом ресурсе есть то, что стоит спрятать и от поисковых роботов, и от посетителей.

Речь идет о дубликатах, профилях пользователей и других страницах с малосодержательным или неуникальным контентом. Их обязательно нужно закрывать от индексации, чтобы сайт не терял позиции в поисковой выдаче. Еще один момент — краулинговый бюджет. Это количество страниц конкретного сайта, которое роботы сканируют за определенное время. Если краулинговый бюджет расходуется на малополезные разделы, то важные данные могут вообще не проиндексироваться.

Ограничить доступ ко всему сайту или конкретным страницам можно по-разному:

- через HTML-код с помощью тега noindex;

- в конфигурационном файле .htaccess;

- через системный файл robots.txt.

Вот о последнем способе мы и расскажем в этой статье.

Что такое файл robots.txt

Иногда встречается название «роботс.тхт», но мы будем говорить правильно — robots.txt. Представим, что этот системный файл выполняет функцию охранника большого офисного центра, т. е. сайта. Когда приходят посетители — поисковые роботы, robots.txt объясняет, куда гостям можно пройти, а где их не ждут. При запрете доступа ко всему ресурсу боты вообще не попадут в «здание».

Файл robots.txt должен быть на любом сайте. Не имеет значения, на какой CMS работает ресурс, — «1С-Битрикс», WordPress и т. д. Например, поисковые роботы могут зайти и увидеть, что на сайте много страниц с фильтрацией, которые генерируются для всех указанных в фильтре свойств. Ботам вряд ли понравится такой «грязный» ресурс. Они решат, что сайт не заслуживает хорошего ранжирования.

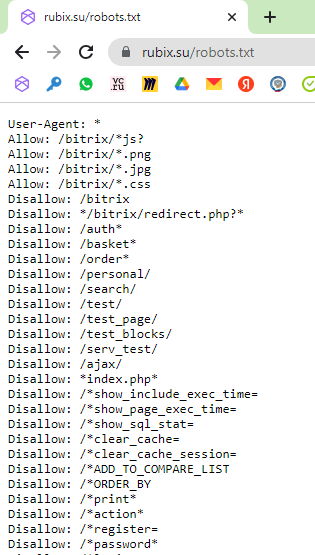

Найти системный файл легко. Достаточно добавить к адресу сайта /robots.txt, и все появится.

*Системный файл robots.txt на сайте Rubix.su

Что можно спрятать с помощью robots.txt

Разберемся, какие секреты умеет хранить системный файл.

*Ваши секреты точно останутся с вами

Фильтрация

Здесь не идет речь о посадочных страницах, которые оптимизированы под поисковые запросы. Их закрывать не нужно. Другое дело, если на сайте много страниц с фильтрацией, которые практически не содержат полезного контента. Их наличие может негативно повлиять на позиции ресурса в выдаче.

Дубли страниц

Это практически неотличимые друг от друга «близнецы» с разными URL, но одинаковым содержимым. Наличие дублей приводит к нескольким проблемам:

- Снижается скорость индексации новых страниц, т. к. поисковым роботам нужно обходить копии, чтобы добраться до свежих данных.

- Поисковые системы «склеивают» дубликаты и самостоятельно определяют, какой вариант будет основным. Здесь возникает риск, что выбранная копия не будет целевой страницей.

- Все дубли остаются доступными для индексации. В таком случае копии начинают конкурировать друг с другом, а это негативно влияет на ранжирование сайта.

Избежать таких проблем помогает robots.txt.

Документы для скачивания

Иногда веб-мастеру нужно скрыть от роботов файлы в формате .doc, PDF и т. д. Решить эту задачу можно с помощью robots.txt.

Здесь важно все тщательно взвесить. Например, внутренние документы и файлы с конфиденциальными данными нужно спрятать. Они не представляют интереса ни для посетителей сайта, ни для поисковых систем. Другое дело, если мы говорим о документах с полезной информацией — ГОСТах, инструкциях по применению и т. д. Такие файлы будут источником дополнительного трафика. После запрета индексации документов важно отслеживать посещаемость.

Страницы в стадии разработки

Проведение редизайна, отсутствие контента, дублирование содержимого — все это причины ограничить доступ к странице. Оставлять ее открытой точно не следует. Дело в том, что недоработанные страницы часто не нравятся поисковым системам и поэтому могут выпадать из индекса. Оптимальный вариант — скрыть «заготовки» с помощью специальной формы либо оставить к ним доступ только для администратора ресурса. Это поможет себя подстраховать. На боевой версии сайта могут случайно остаться ссылки на недоработанные страницы, а полное ограничение доступа позволит избежать неприятностей.

Служебные страницы

Технические страницы без полезного контента также стоит скрыть от роботов. Личный кабинет, корзина, результаты поиска по сайту — все это только мешает индексации.

Папки

Как правило, файлы сайта распределяются по папкам — категориям, каталогам и т. д. Robots.txt позволяет веб-мастеру быстро решить вопрос, если тот или иной раздел полностью устарел. В таком случае можно не тратить время на ограничение доступа к каждой неактуальной странице, а сразу закрыть всю папку. Главное — случайно не спрятать файлы, которые могут быть полезны для ранжирования.

Изображения

С помощью robots.txt веб-мастера могут запретить индексацию не только страниц или разделов, но и картинок. Если речь идет об уникальных полезных изображениях, то ограничивать к ним доступ не стоит.

Ссылки

Запретить индексирование конкретной ссылки с помощью robots.txt не получится. Для выполнения этой задачи подходит атрибут rel. Что касается robots.txt, то он позволяет:

- скрыть страницу, на которой размещается ссылка;

- ограничить доступ к странице, на которую ведет ссылка.

Отдельные блоки

Здесь robots.txt тоже не работает. Чтобы скрыть отдельные блоки от поисковых роботов Яндекса, можно использовать тег noindex. С Google немного сложнее, но и здесь есть выход. Можно воспользоваться одним из нескольких способов — каждый из них по-своему хорош.

*Это лучше спрятать

Мы разобрались с тем, что позволяет спрятать robots.txt. Перейдем к тому, какими способами можно скрывать информацию с помощью системного файла.

Как запретить индексацию всего сайта

Чтобы ресурс стал для поисковых систем невидимкой, нужно открыть robots.txt и написать в нем две строки:

User-agent: *

Disallow: /

Директива user-agent связана с роботом, который подчиняется описанным в robots.txt правилам. Символ * указывает, на какие поисковые системы распространяется запрет. При необходимости спрятать сайт от конкретного робота, в user-agent нужно внести его название — Yandex или Googlebot.

Слово disallow означает «запретить». Косой слеш указывает на то, что все страницы сайта должны быть закрытыми от поисковиков.

Альтернативная директива allow — «разрешить» — позволяет открыть ресурс только для одного бота. Чтобы ее применить, нужно написать следующие строки:

User-agent: *

Disallow: /

User-agent: YandexImages

Allow: /

В нашем примере мы закрываем сайт для всех поисковых роботов. Доступ к ресурсу остается только у того бота, который сканирует изображения для Яндекс.Картинок. Директива allow также позволяет закрыть сайт от одного конкретного поисковика и оставить доступ для других.

Как запретить индексацию отдельной страницы

Здесь тоже нет ничего сложного. Нужно открыть robots.txt и написать:

User-agent: *

Disallow: /page.html

В этом случае директива disallow включает относительный адрес той страницы, которую необходимо спрятать от ботов. Не нужно полностью прописывать URL, указывать префикс и домен — достаточно части ссылки после первого слеша.

Чтобы закрыть от индексации сразу несколько страниц, следует использовать директиву disallow для каждой из них отдельно. Перечислить их через пробел не получится — это ошибка.

Как запретить индексацию папки

Для решения этой задачи снова потребуется директива disallow. С ее помощью можно скрыть конкретный раздел либо папку с файлами. Например, нужно спрятать от ботов каталог. Для этого необходимо добавить в robots.txt следующее:

User-agent: *

Disallow: /catalog/

Вместо /catalog/ можно написать имя любой папки, к которой нужно ограничить доступ. Важно: с обеих сторон от названия должен стоять косой слеш. Если все сделано правильно, поисковые роботы не будут замечать все страницы или файлы внутри директории.

Иногда веб-мастеру нужно ограничить доступ к папке, но таким образом, чтобы оставить открытым для индексации конкретный объект. В таком случае потребуется директива allow:

User-agent:*

Disallow: /catalog/

Allow: /catalog/file.php

Здесь file.php — это имя конкретного файла. Можно сделать еще проще. Если заменить название символом *, получится *.php. Таким образом, можно скрыть все файлы с расширением PHP, которые содержит конкретная папка.

Как запретить индексацию изображений

Для полного ограничения доступа к картинкам нужно прописать:

User-Agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gif

Чтобы избежать ошибки, важно правильно указать формат.

Как ограничить доступ к поддомену

Обычно у каждого поддомена есть свой robots.txt — он находится в корневой папке. Чтобы запретить индексацию, нужно открыть системный файл и написать:

User-agent: *

Disallow: /

Список наиболее популярных поисковых роботов

Файл robots.txt позволяет обратиться по имени к боту конкретной поисковой системы. Вот список основных роботов:

- Yandex (Яндекс).

- Googlebot (Google).

- SputnikBot (Спутник).

- MSNBot (Microsoft Network Search).

- Slurp (Yahoo!).

Как проверить robots.txt

Сначала нужно убедиться, что файл без проблем открывается. Для этого необходимо ввести в строку браузера адрес своего сайта и добавить к нему robots.txt. Это должно выглядеть так:

https://sitename.ru/robots.txt

Затем нужно проверить файл с помощью «Яндекс.Вебмастера» и Google Search Console. Разберемся, как это сделать.

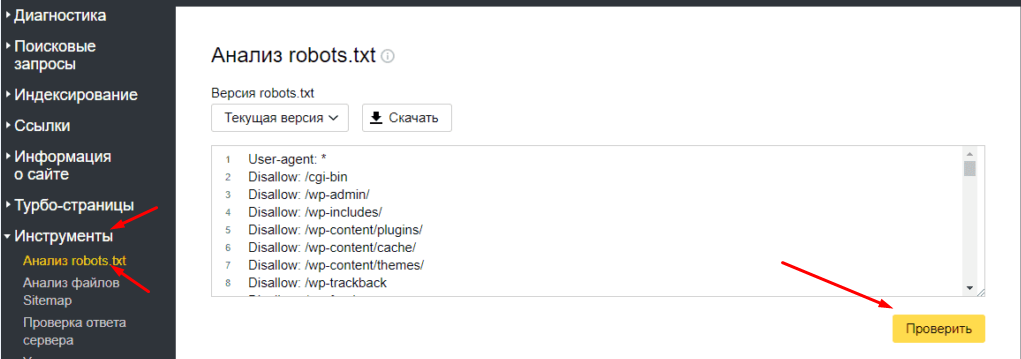

«Яндекс.Вебмастер»

Нужно зайти в «Инструменты» и открыть «Анализ robots.txt». Содержимое файла должно отобразиться в строке. После этого нужно нажать «Проверить». Если в файле обнаружатся ошибки «Яндекс.Вебмастер» предложит способы их исправить.

*Проверка robots.txt через Яндекс.Вебмастер

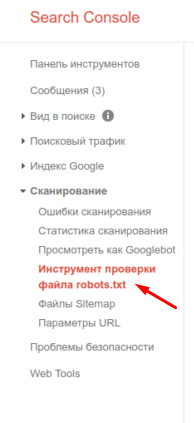

Google Search Console

Веб-мастеру нужно авторизоваться в аккаунте и зайти в инструмент проверки robots.txt. После этого откроется окно, в котором отобразится подгруженная информация из файла. Если она не появится, ее можно будет вставить из браузера. После этого Google Search Console проверит файл на наличие ошибок и предложит методы их устранения.

*robots.txt можно проверить и через Google Search Console

Еще раз о главном

Robots.txt позволяет ограничить доступ к малосодержательному контенту — техническим страницам, служебным документам, конфиденциальным данным пользователей и т. д. С помощью системного файла можно полностью закрыть ресурс от индексации, если на сайте проводятся работы.

Выяснить, какие страницы видны роботам, а какие нет, позволяют «Яндекс.Вебмастер» и Google Search Console. Эти же сервисы помогают проверить, правильно ли заполнен системный файл.

Благодаря robots.txt вы легко можете закрыть от индексации страницу, раздел или весь сайт целиком. Выполнение этой задачи не требует много времени и усилий. А чтобы не пропускать статьи об интернет-маркетинге от Rubix, подписывайтесь на наш Telegram-канал!